SanDisk vừa công bố bước tiến lớn trong ngành bộ nhớ khi bắt tay cùng SK hynix để hiện thực hóa công nghệ High Bandwidth Flash (HBF). Đây là giải pháp hứa hẹn mang lại dung lượng bộ nhớ vượt trội cho GPU AI, với khả năng cao gấp 8–16 lần so với HBM nhưng vẫn giữ mức chi phí tương đương.

SanDisk High Bandwidth Flash – Công nghệ lai giữa NAND và HBM

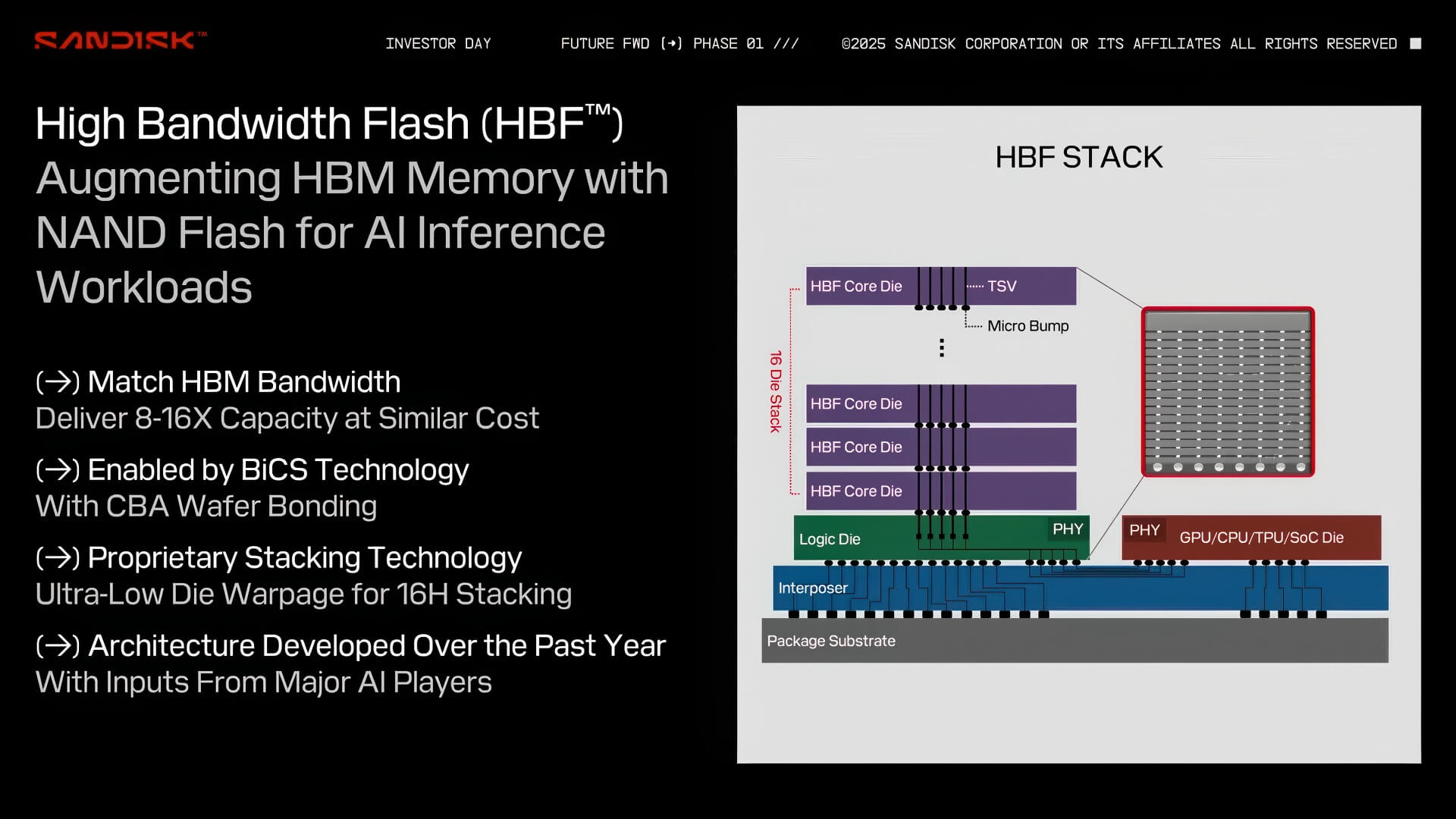

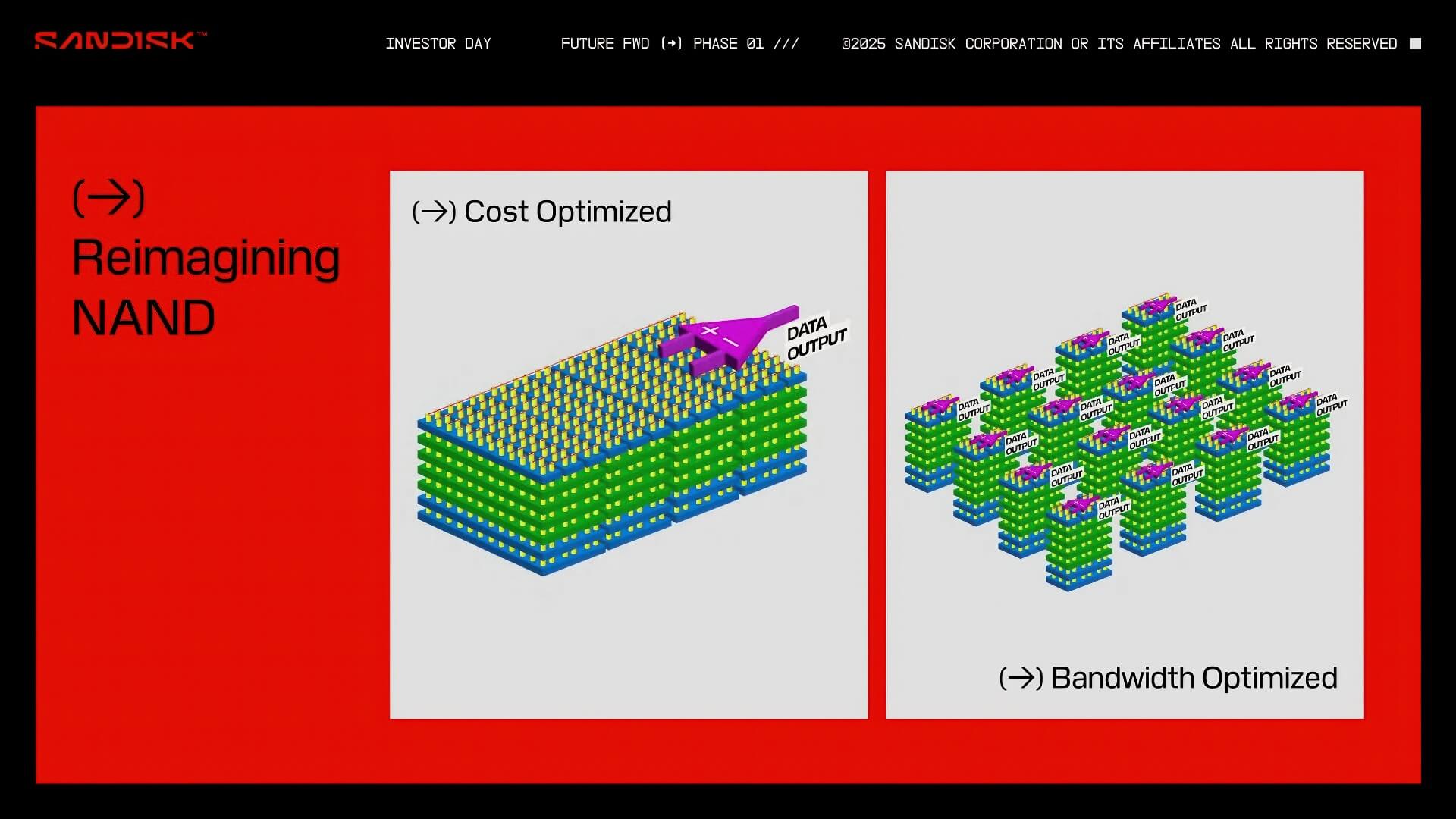

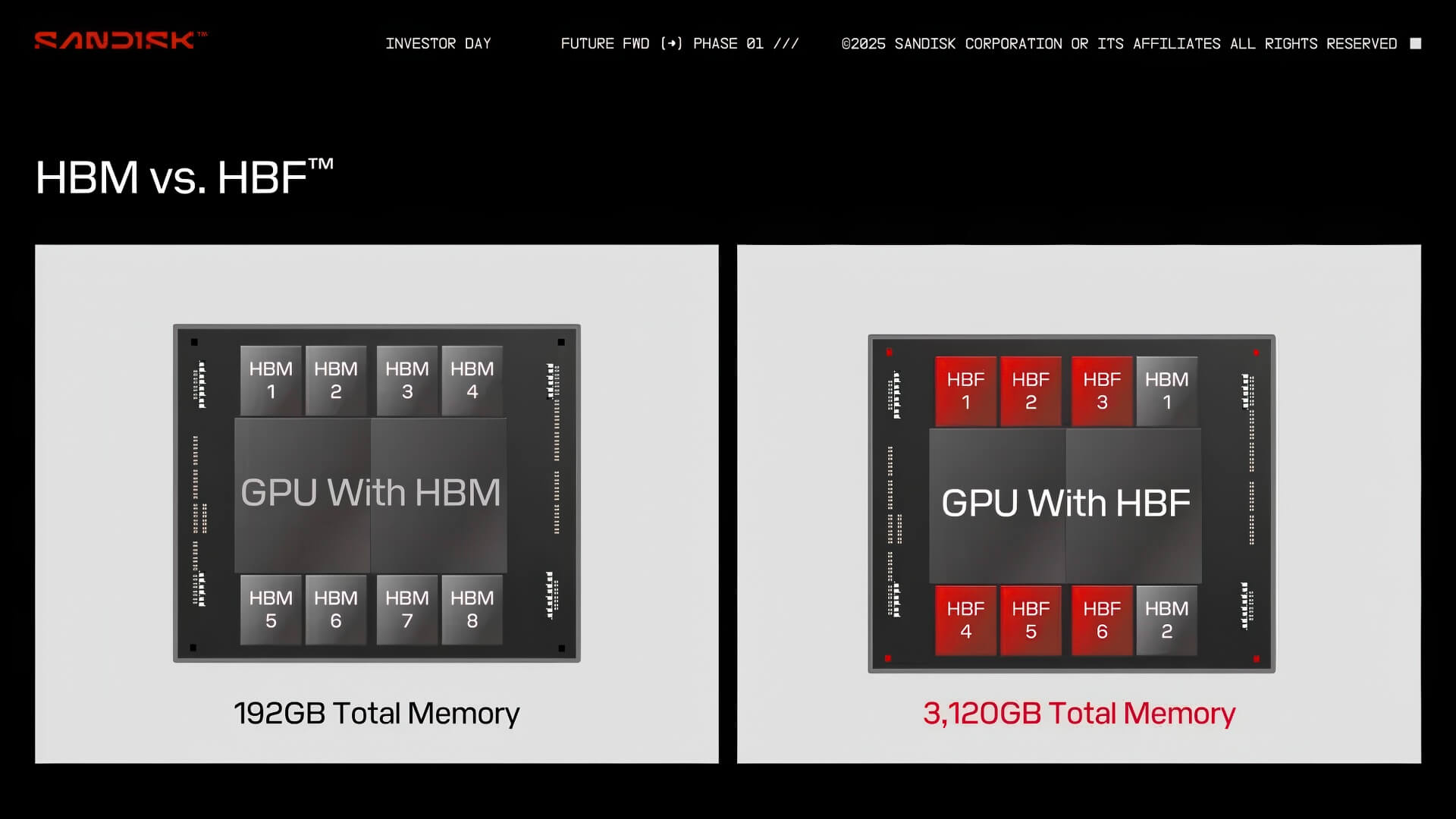

HBF là công nghệ bộ nhớ mới được SanDisk giới thiệu đầu năm nay, kết hợp dung lượng lưu trữ khổng lồ của chip 3D NAND với tốc độ truyền dữ liệu cao của HBM. Thiết kế này cho phép xếp chồng dọc 8 lớp HBF, tạo ra dung lượng tới 4TB trên một chip duy nhất. Điều này mở ra khả năng lưu trữ trực tiếp các mô hình ngôn ngữ lớn như GPT-4 ngay trong VRAM của GPU, loại bỏ nhu cầu truy cập SSD hay lưu trữ cục bộ.

SanDisk nhấn mạnh rằng HBF được tối ưu cho khối lượng công việc suy luận AI, vốn đòi hỏi băng thông cao và dung lượng lớn. Công nghệ này hướng tới nhiều đối tượng từ các trung tâm dữ liệu quy mô lớn, doanh nghiệp vừa và nhỏ, cho tới các ứng dụng điện toán biên.

Hợp tác chiến lược với SK hynix

SK hynix – một trong những nhà sản xuất bán dẫn hàng đầu thế giới – sẽ cùng SanDisk xây dựng bộ tiêu chuẩn chung cho HBF, bao gồm yêu cầu kỹ thuật và định hướng phát triển hệ sinh thái. Sự hợp tác này được kỳ vọng sẽ đẩy nhanh tiến độ thương mại hóa HBF và mở rộng thị trường.

Theo ông Hyun Ahn, Chủ tịch SK hynix, nhu cầu về giải pháp lưu trữ và bộ nhớ hiệu suất cao, dung lượng lớn đang tăng mạnh để phục vụ công nghệ IT thế hệ mới. Việc chuẩn hóa HBF sẽ giúp thúc đẩy đổi mới và đáp ứng nhu cầu ngày càng cao từ ngành AI.

Lộ trình ra mắt và tiềm năng thị trường

SanDisk cho biết HBF có thể cung cấp dung lượng gấp 8–16 lần HBM với cùng mức giá, tạo lợi thế cạnh tranh đáng kể cho các ứng dụng AI. Hai công ty sẽ thành lập Hội đồng Cố vấn Kỹ thuật để giám sát quá trình phát triển và chiến lược tiếp thị.

Các mẫu chip HBF thử nghiệm dự kiến xuất hiện vào nửa cuối năm 2026, trong khi sản phẩm thương mại đầu tiên cho AI inference sẽ ra mắt vào đầu năm 2027. Nếu thành công, HBF có thể trở thành bước ngoặt trong ngành bộ nhớ, giúp GPU AI xử lý khối lượng dữ liệu khổng lồ nhanh hơn và hiệu quả hơn.